Les gens sont durs sur Reddit ![]()

C’est le jeu, et c’est justement un succès quand on attire ce genre de comptes ![]()

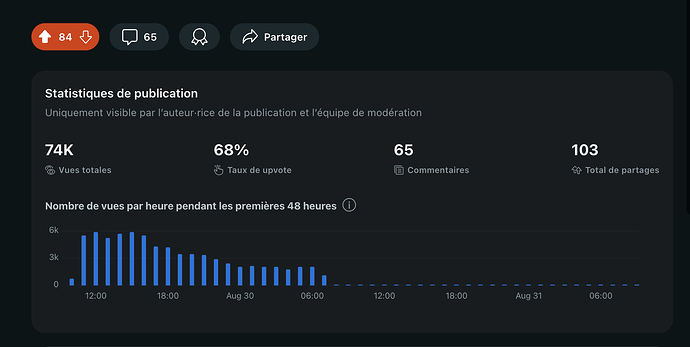

ça créé de l’engagement, et donc de la vue ^^ Pour moi c’est un succès !

Je suis tous les jours sur reddit, et c’est rempli de gens dédaigneux, quelque soit le sub ^^

Mais 30 commentaires en quelques heures, c’est que ce topic marche bien !!

Je sais pourquoi je ne reste pas longtemps sur Reddit ou sur les réseaux sociaux !! La nature humaine est parfois au-delà de l’imaginable ![]()

Merci pour ces améliorations, sur mon instance ce n’est pas aussi pertinent que pour vous autres au vu de la taille originale mais ça reste intéressant. Le fichier SQLite passe de 2 Go à 3.3 Mo.

Le fichier DuckDB est de 3.1 Mo

![]()

Une petite question @pierre-gilles, est-ce que tu prévois dans quelques versions de supprimer le code de migration ou vas tu le laisser quelques temps ? Lors des dernières vacances j’ai commencé l’installation de Gladys chez mes parents, ça a tourné quelques semaines et j’ai éteint l’instance quand je suis parti. Je veux juste m’assurer que si je la redémarre dans quelques semaines, il y aura toujours le système de migration automatique

Aha, idem, mais franchement je trouve que globalement le subreddit a été plutôt soft. C’est une réussite ce post !

Il ne faut pas se laisser démoraliser par les quelques grincheux ![]()

Génial ! ![]()

Ah je pense qu’il va rester à vie dans Gladys. Toutes les migrations de DB sont dans le code depuis le début sont là, et servent à toute personne qui est encore en 4.0.0 et migre plus tard (il y en a!)

On masquera peut-être la partie UI dans un endroit plus caché, mais on ne coupe pas à garder la migration à vie.

Bonjour,

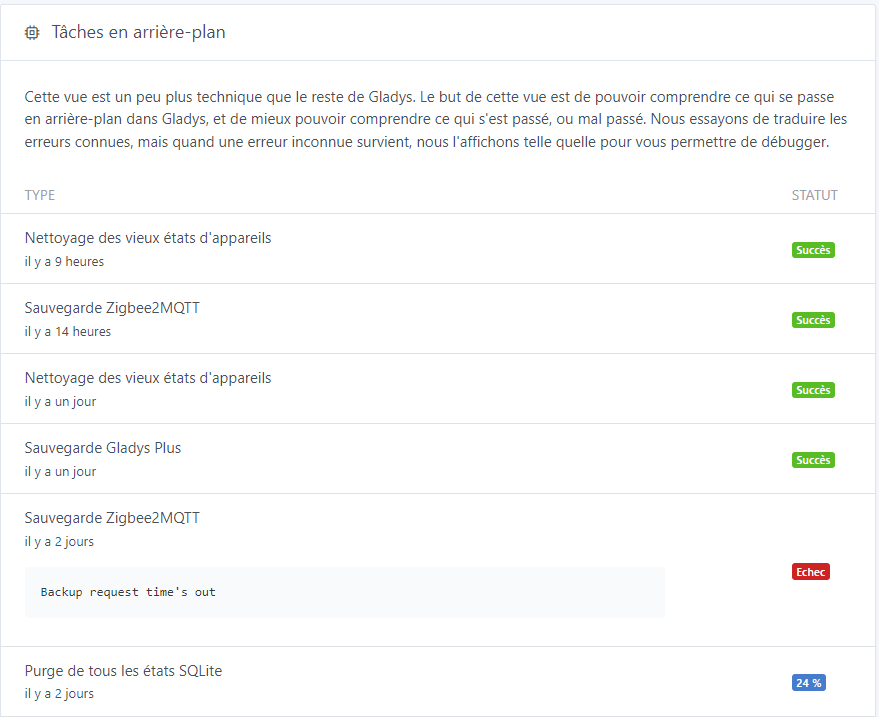

La purge chez moi ne fonctionne pas et sur la page système, la migration mouline de nouveau.

Je ne sais pas quoi faire au vu des éléments suivants :

Tu as quoi dans l’onglet « Système » ? Est ce que une partie de la migration s’est faite ?

j ai meme pb que @Jluc .

la migration duckdb est apparemment faite (visible dans tache).

mais par contre la purge sqlite n a pas l air de se faire ou du moins au ralenti (3%en 2 j, hier) et la sur systeme /migration duck le sablier mouline sans que je vois l avancement, et mon serveur gladys est hyper ralenti ! (pb de rafraissement des info sur mes dashboard !

Bravo, pour ce trés beau travail. La mise à jour et la migration ont été réalisées directement et en autonomie totale. Je découvre dans le même temps DuckDB qui est particulièrement efficace. Merci

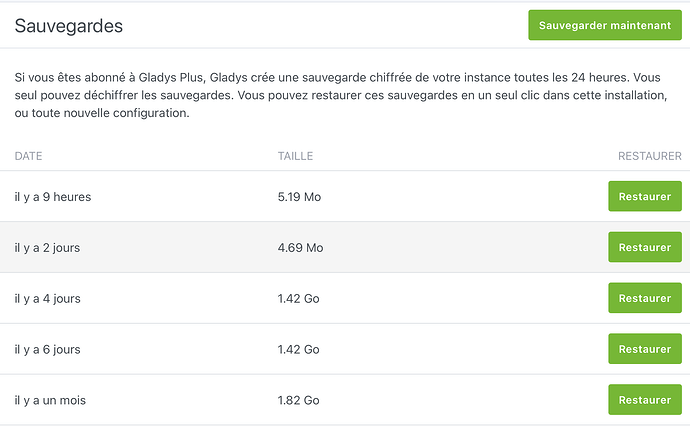

Pour moi, la migration vers DuckDB c’est bien passé, quand a la purge SQlite elle affiche 24% dans les jobs :

Alors que dans system le nombre d’états SQlite est a zéro :

Je pense que je peux nettoyer la base de données maintenant ? ![]()

Absolument!

@Jluc sais-tu redémarrer ton container Gladys (ou redémarrer ta machine) ?

Et ensuite relancer la purge…

Màj effectuée sur PI3.

Problème suite à l’étape « Purger les états SQLite ». Gladys planté, le Pi mettait 3 min à répondre à une ligne de commande.

Docker stop gladys

Docker start gladys

J’ai ensuite lancé le nettoyage de la BDD.

Avant:

Après:

![]()

Résultat, BDD divisée par 3123.

Bonjour tout le monde,

Je ne vais pas vous apporter beaucoup d’info mais pour vous dire que tout s’est très bien passé : La mise à jour s’est effectuée toute seule sans erreur, et j’ai lancé la purge des états SQLite qui s’est bien déroulée également.

Bon travail !

Bonjour à tous,

Pour moi, egalement passage à DuckDB sans accro , avant la base etait de 3.76Go et maintenant elle fait 287.77Mo

Comme d’habitude, Super boulot @pierre-gilles, merci encore

Bonjour @GBoulvin,

Ce matin la purge s’affiche à 31% et j’ai bon espoir qu’elle ira jusqu’au bout.

Gladys tourne sur un Pi 3b, c’est lui qu’il faudrait redémarrer ? Si c’est ça, je pourrais le faire par contre, je ne sais pas gérer les containers.

Aussi, depuis deux jour la sauvegarde Zigbee2mqtt est en échec.

Cher @Jluc,

Pas d’inquiétude, ça avance !

Ne fais donc rien pour le moment…

La sauvegarde est en erreur car ton Raspberry est saturé. Malheureusement, il n’y a rien à faire que de patienter. Il faut qu’il traite toutes les entrées de la base de données et tout rentrera dans l’ordre ensuite !

Bon courage !

Chez moi, je suis passé de 732 mega à moins de 5 et ca tourne comme avant. Merci pour l’amélioration.