Hello @pierre-gilles,

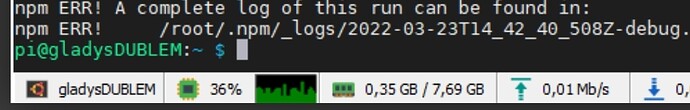

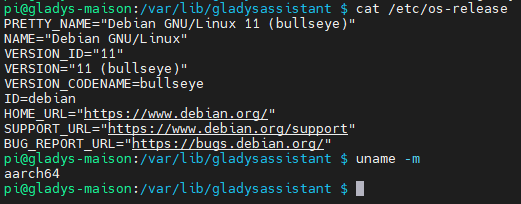

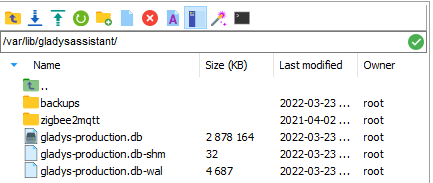

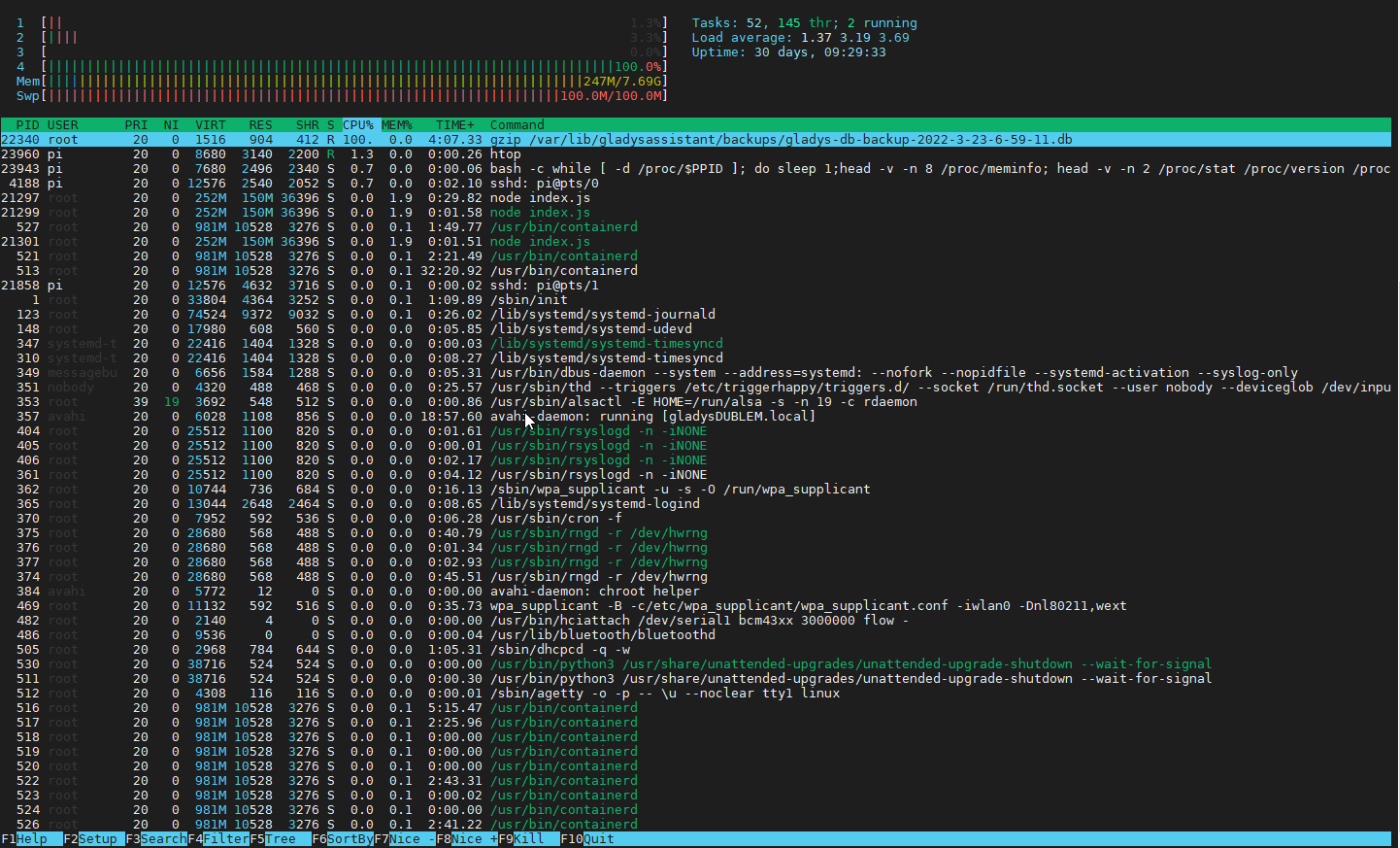

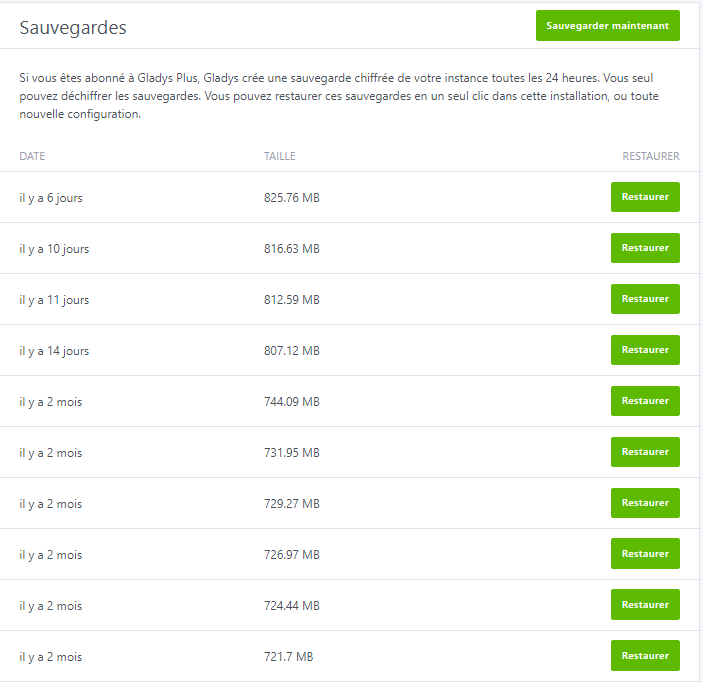

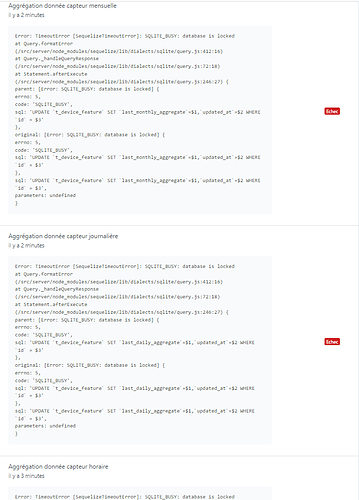

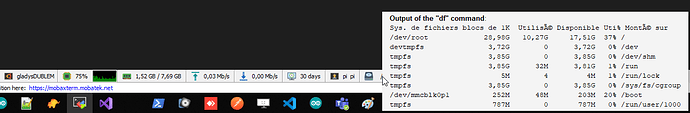

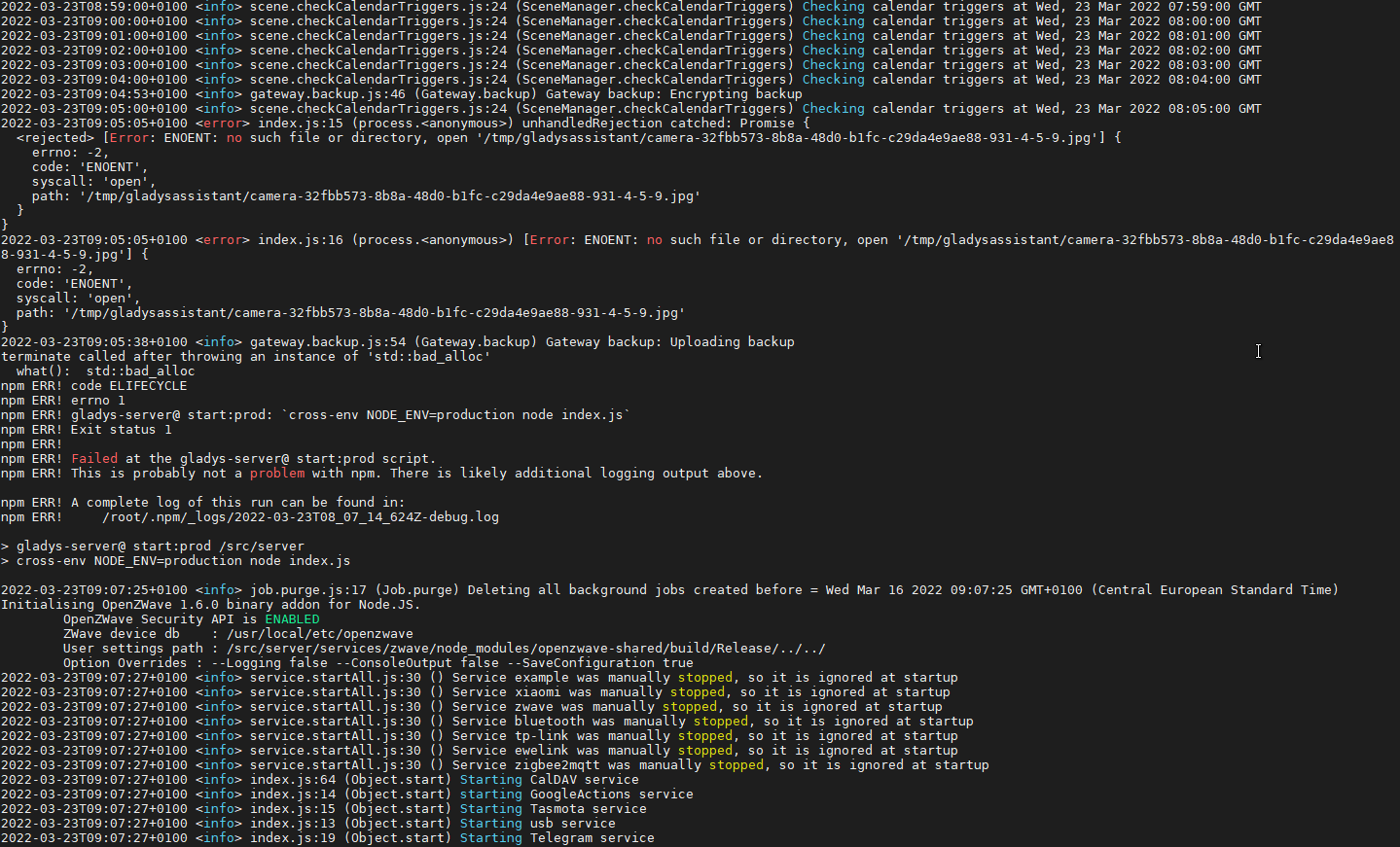

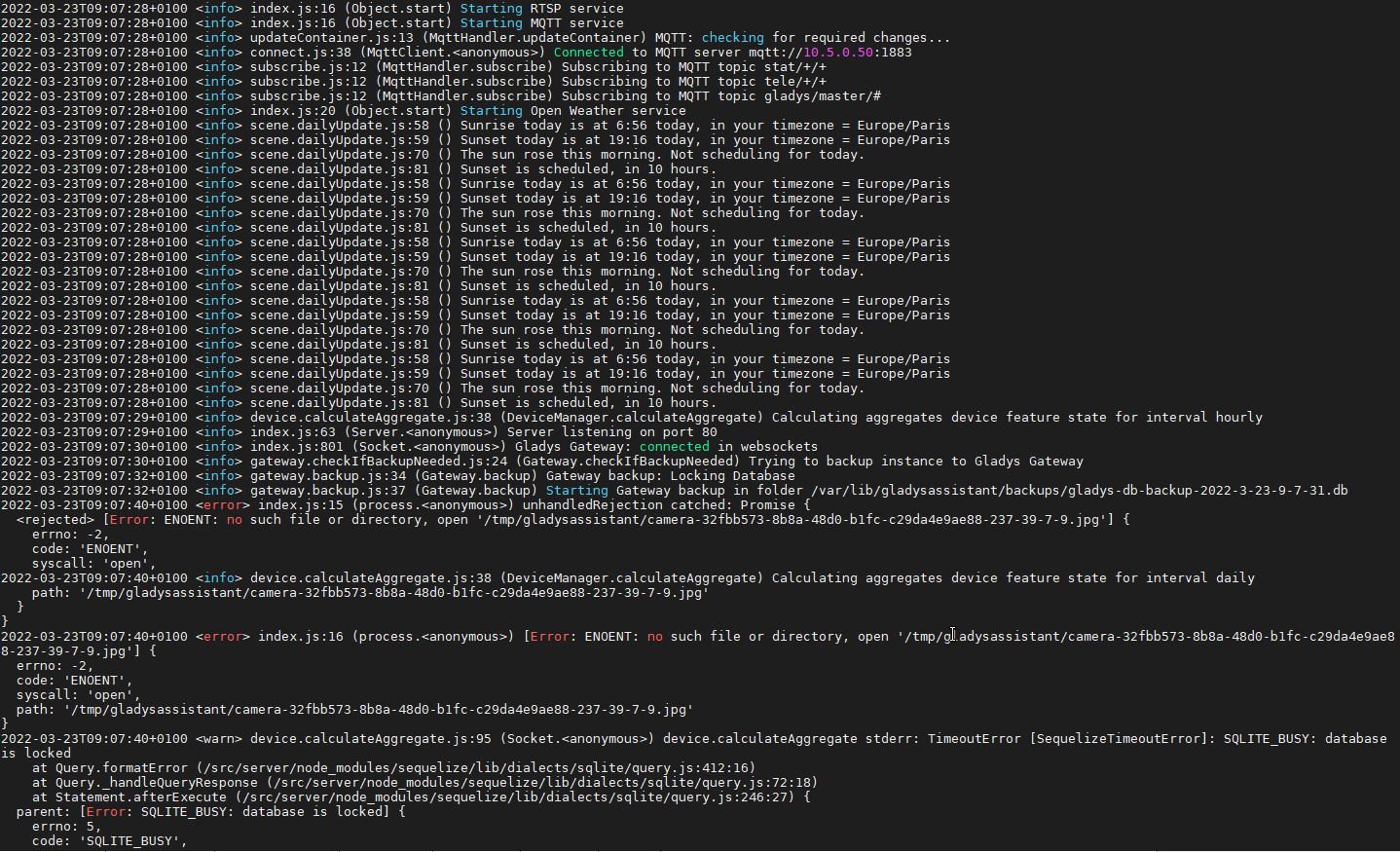

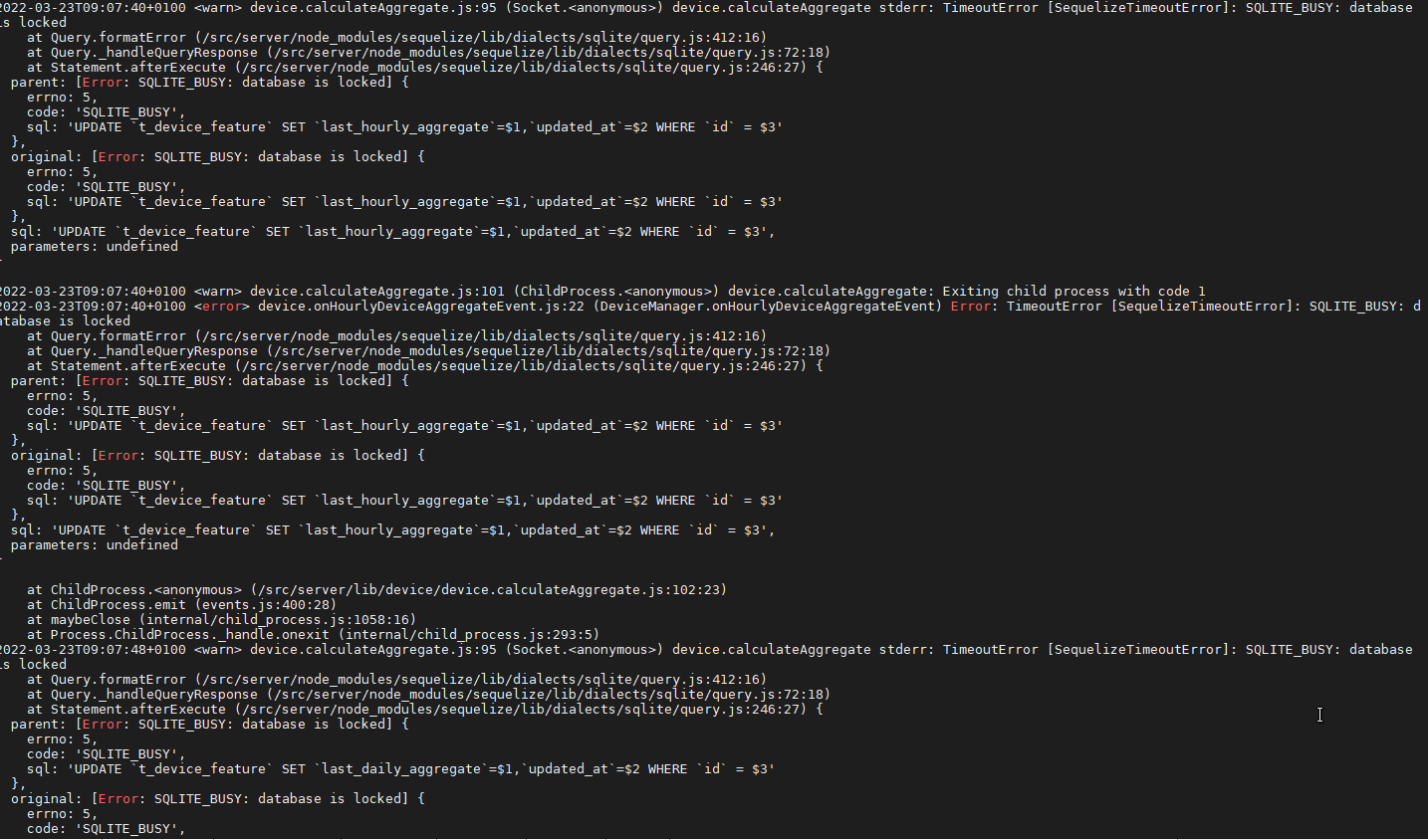

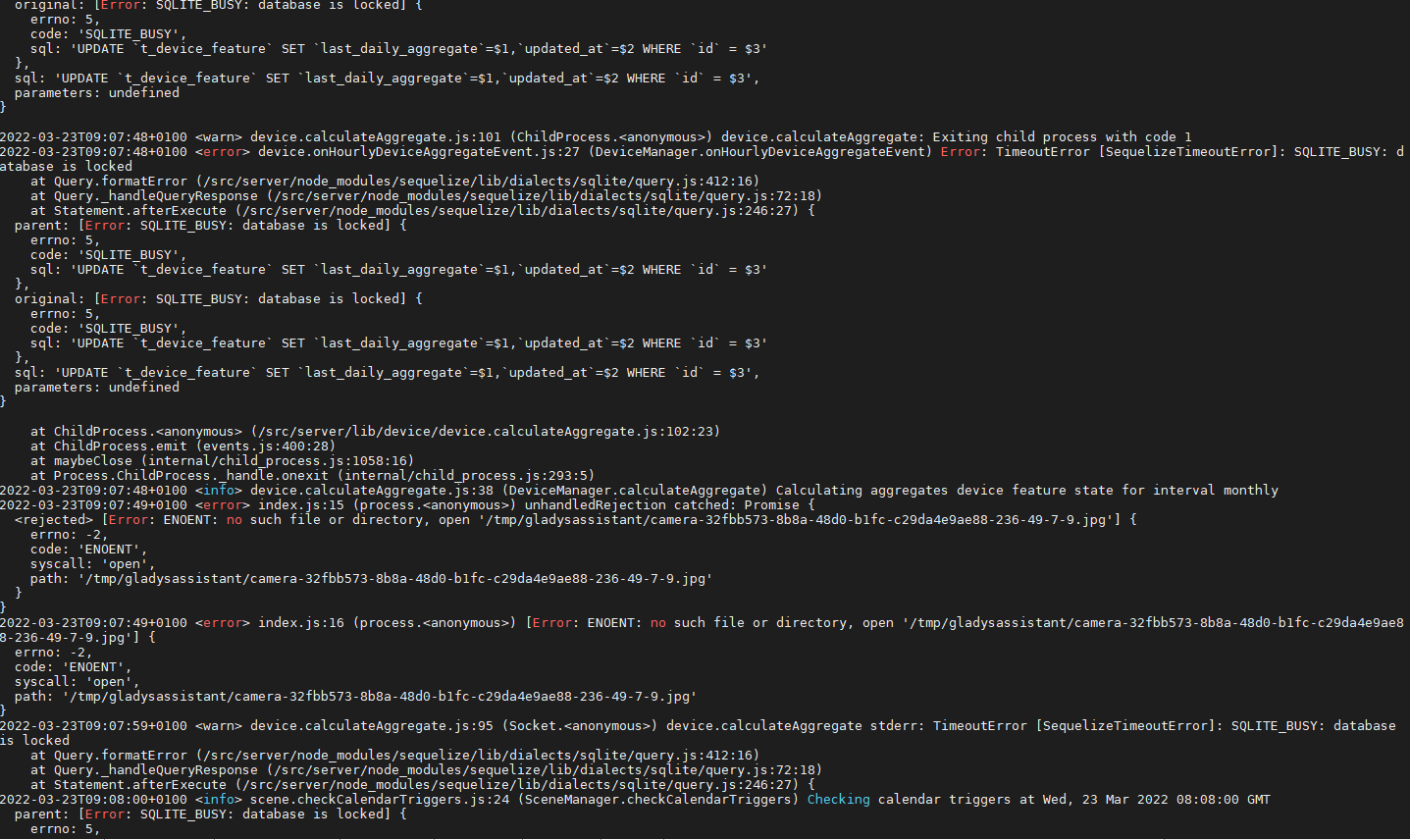

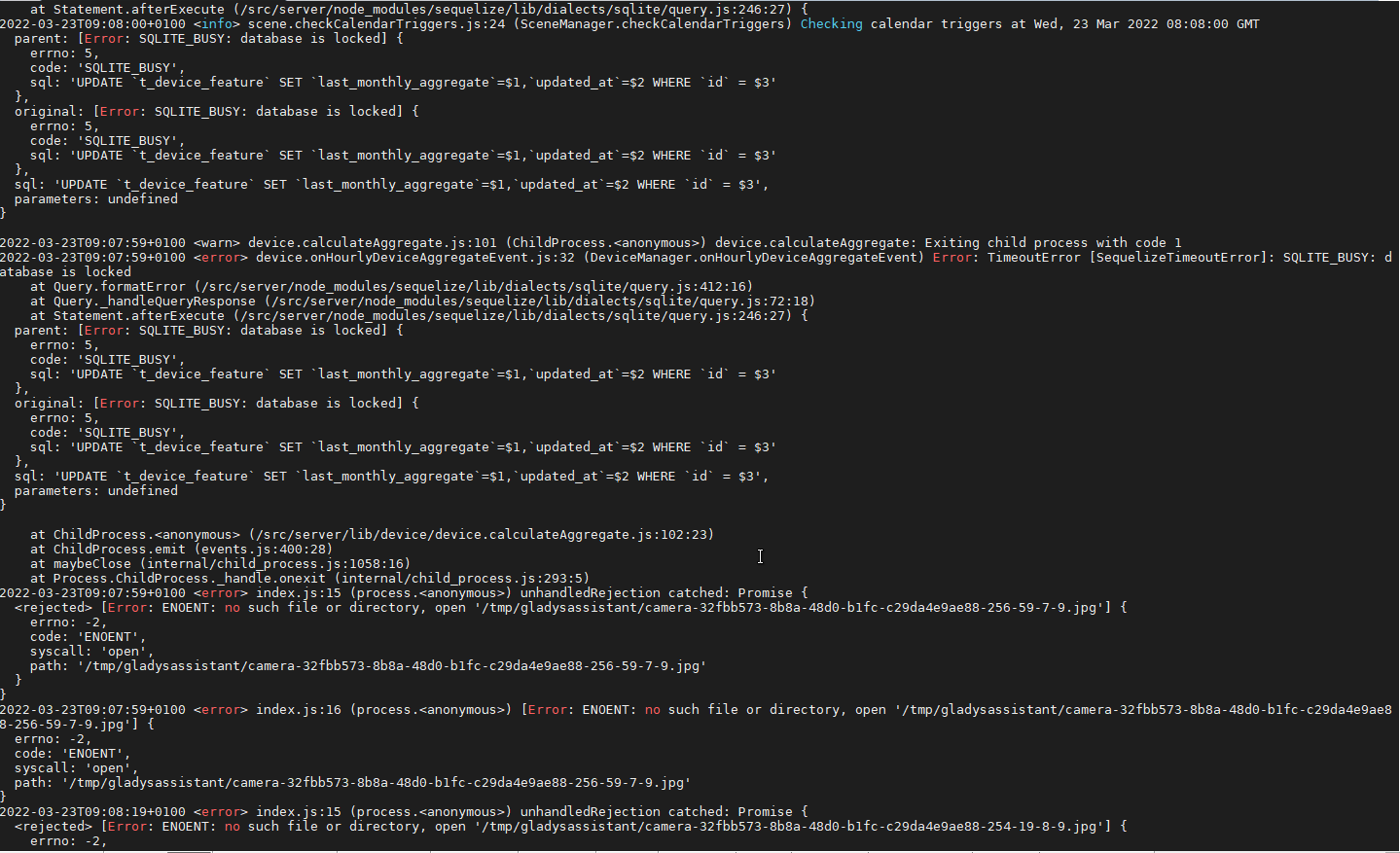

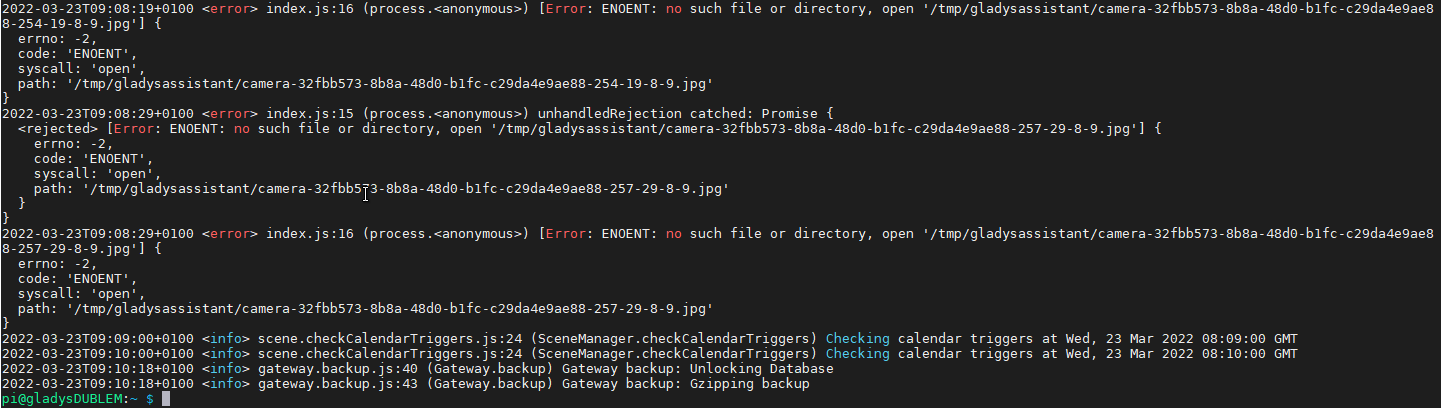

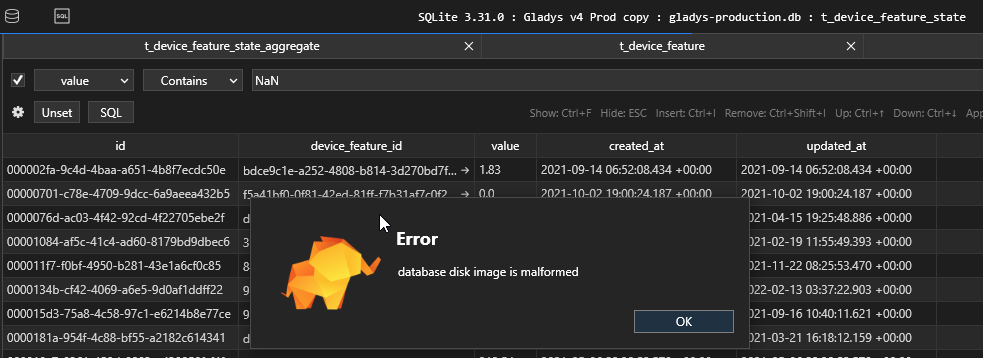

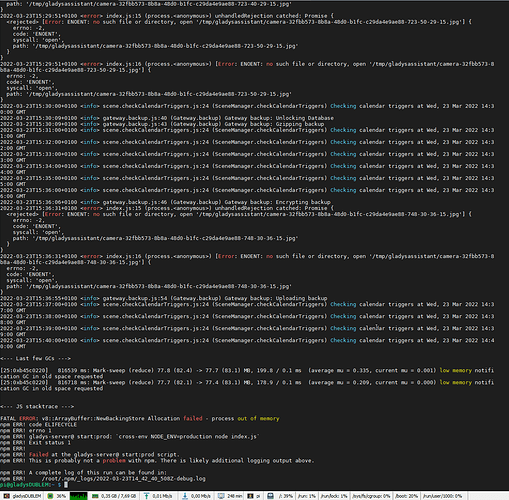

Bon je suis désolé, je reviens avec de “mauvaises” nouvelles, les problèmes de perf sont toujours présent et toujours avec la même cause : ressources prises par le backup de la base de donnée. Cela ce traduit toujours pas une perte d’accès à Gladys pendant 4/5 minutes toutes les 30 minutes, des backup Gladys Plus très aléatoires, des erreurs sur l’aggrégation permanentes. Cela fait environ 2 mois que ça bug de nouveau(passage du backup au delà de 750Mo ?)

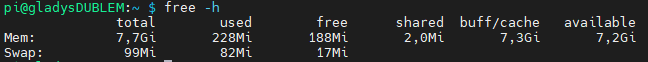

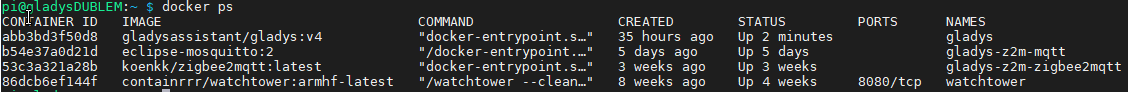

Taille de la DB sur le pi

Edit :

Je pensais pourtant que tu avais mis en place des choses pour empêcher de se retrouver sur des problèmes d’accès à la DB pendant le backup. N’y aurait-il pas eu une régression sur ce point ? Ou je me trompe ?

Suite à votre dernière vidéo cela m’a motiver à reprendre la partie prog solaire grâce à node red. J’ai donc de nombreuse données supplémentaires à intégrer (production sur 3 phases + cumul / consommation sur 3 phases et 3 parcs + cumul / différences entre les 2) Ca représente environ 72 features dont 12 valeurs toutes les 30s, 24 valeurs toutes les 1h, 12 valeurs tout les jours, 12 valeurs mensuelles et 12 valeurs annuelles.

Pour le coup cela m’inquiète un peu pour le futur. N’y a-t-il pas moyen de couper le backup. Mon SSD étant lui tout à fait capable de gérer la sauvegarde de ces données, je passerais bien par une sauvegarde en interne si c’est seulement Gladys Plus qui pose problème.

Pour info je suis en pleine campagne, je fonctionne sur 3 réseaux internet (satellite starlink en prio, free 4G en secondaire et free adsl - 512Ko en secours) qui coupe chacun régulièrement. Mais le débit Starlink est excellent (120 méga en moyenne). Est-ce que une coupure internet pendant la sauvegarde peux expliquer cela ?

Merci par avance.

C’est cool, ça va nous permettre de bétonner encore plus le logiciel

C’est cool, ça va nous permettre de bétonner encore plus le logiciel