Salut à tous !

Un petit post pour vous présenter Gladys Assistant v4.25.1, sorti vendredi dernier et qui devrait déjà être déployé sur vos instances ![]()

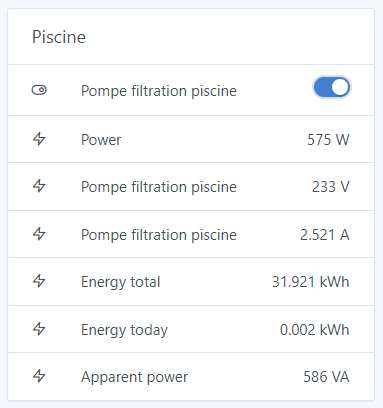

Améliorations Tasmota autour du suivi de consommation

Il y avait plusieurs problèmes d’unités avec l’intégration Tasmota sur les fonctionnalités de suivi de consommation, et c’est maintenant corrigé dans Gladys :

Merci @Terdious pour la PR, et @GBoulvin pour les tests ![]()

Correction d’un bug lié aux caméras (ffmpeg)

Chez certains utilisateurs, lorsque leur caméra ne répondait pas bien aux requêtes Gladys, les process ffmpeg restaient actifs et s’accumulaient sur le système de l’utilisateur, prenant de la RAM inutilement.

Cette mise à jour limite les requêtes pour aller chercher une image de caméra à 10 secondes.

Au delà, le process est tué pour éviter de saturer la RAM.

Merci à @lmilcent qui a remonté le bug ![]()

Correction d’un bug dans l’interface d’édition de scènes

Le bouton « Executer seulement lorsque le seuil est passé » n’était plus cliquable.

C’est désormais corrigé.

Correction d’un bug sur le nouveau widget « Appareils »

Le nouveau widget « Appareils » a fait son entrée dans la dernière version de Gladys, et il y avait un bug sur les volets roulants qui n’étaient pas contrôlables.

C’est désormais corrigé dans cette version.

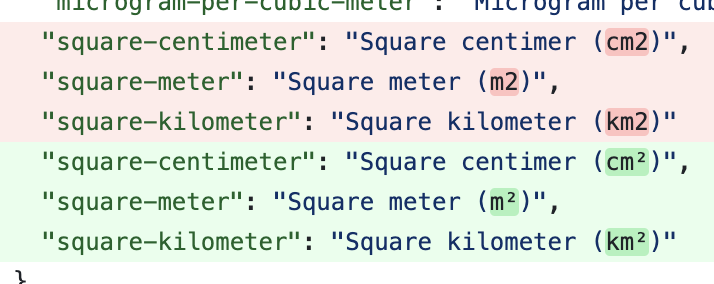

Amélioration des unités m²

Toutes les unités avec un exposant ont désormais l’exposant et non pas juste un « 2 »

Le changelog complet est disponible ici .

Comment mettre à jour ?

Si vous avez installé Gladys avec l’image Raspberry Pi OS officielle, vos instances se mettront à jour automatiquement dans les heures à venir. Cela peut prendre jusqu’à 24h, pas de panique.

Si vous avez installé Gladys avec Docker, vérifiez que vous utilisez bien Watchtower ( Voir la documentation )